🎉 Microsoft dévoile un outil révolutionnaire : convertir les captures d’écran en actions concrètes pour les agents IA

🤖 Une avancée qui propulse l’agenticité UI des modèles d’IA, comme GPT-4V, à un nouveau niveau. Ce nouvel outil, OmniParser, transforme les captures d’écran en structures ordonnées, permettant aux modèles d’IA de mieux comprendre, segmenter et interagir avec l’interface.

🔍 Pourquoi OmniParser marque-t-il une innovation technique ?

Les modèles multimodaux comme GPT-4V excellaient dans la compréhension contextuelle, mais restaient limités dans leur capacité à effectuer des actions précises. Avec cet outil :

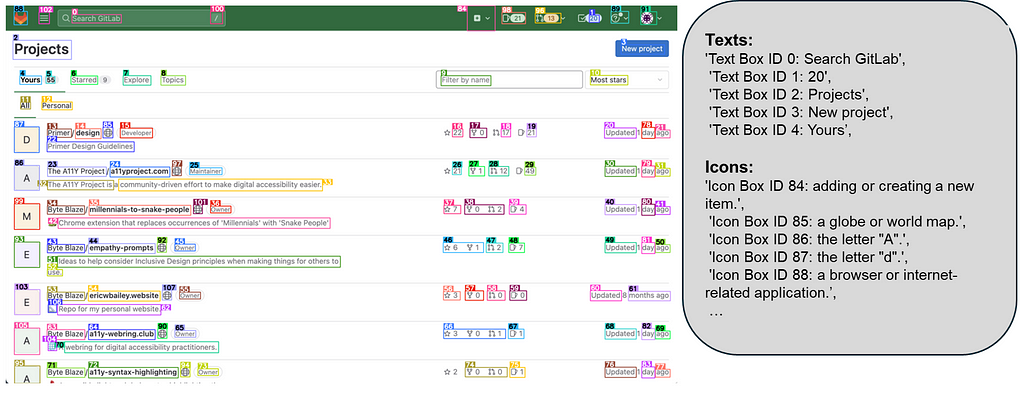

1️⃣ Une détection rigoureuse des icônes interactives grâce au modèle YOLOv8, entraîné pour identifier les régions cliquables et les actions potentielles.

2️⃣ Une analyse sémantique des éléments d’interface, affinée avec BLIP-2, associant chaque icône à une fonctionnalité et améliorant ainsi la précision des actions déclenchées.

📊 Données d’entraînement et modèles utilisés : le socle de la robustesse de cet outil

Pour garantir une reconnaissance contextuelle approfondie, Microsoft a créé deux ensembles de données spécialisés :

- Dataset d’icônes interactives : Curé à partir de pages web populaires, ce dataset contient plus de 67 000 images uniques, annotées pour repérer les zones cliquables et actionnables.

- Dataset de description des icônes : Enrichi par un échantillon de 7 000 paires icône-description, il offre un contexte fonctionnel détaillé pour des tâches de classification et d’activation en UI.

🚀 Applications concrètes et cas d’usage

Ce système ouvre la voie à une multitude d’applications pour les agents IA sur interfaces utilisateurs :

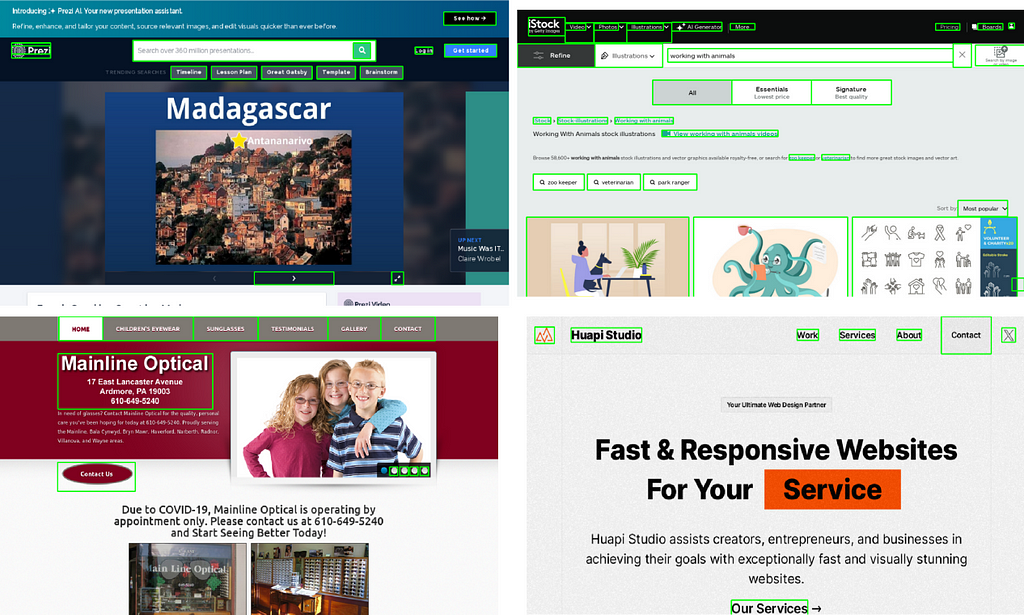

- Automatisation des processus métiers : Permet à un agent IA d’effectuer des tâches répétitives dans des logiciels d’entreprise (CRM, ERP, etc.) en interagissant de manière autonome avec l’interface.

- Accessibilité et assistance numérique : Facilite l’interaction pour les personnes en situation de handicap, en rendant l’interface accessible via une compréhension visuelle automatisée.

- Navigation Web intelligente : Permet une navigation autonome sur les sites web, avec interaction sur les formulaires et boutons pour la recherche ou la veille stratégique.

🛠️ Fonctionnalités techniques clés :

- Détection des régions interactives : Un modèle personnalisé isole les zones cliquables en superposant des boîtes de détection identifiées pour éviter la prédiction approximative de coordonnées.

- Incorporation des sémantiques locales : Chaque icône ou texte est accompagné d’un contexte sémantique grâce au modèle BLIP-2, affinant les prédictions d’action en levant les ambiguïtés.

🌐 Vers un Claude Computer open source ?

Les innovations apportées par cet outil de parsing d’écran pourraient ouvrir la voie à la création d’un “Claude Computer” open source. En rendant possible l’interaction directe avec des interfaces utilisateurs de façon fluide, ce système permettrait à un modèle d’IA comme Claude d’aller au-delà de la simple réponse textuelle et d’interagir avec des applications visuelles. OmniParser fournit les bases pour un assistant numérique capable de naviguer, d’analyser et d’agir directement sur les interfaces, devenant ainsi un véritable outil autonome.

Cela rejoint les ambitions décrites dans l’article “Anthropic frappe fort avec la sortie de Claude 3.5 Haiku et Claude 3.5 Sonnet” : https://medium.com/ia-web3/anthropic-frappe-fort-avec-la-sortie-de-claude-3-5-haiku-et-claude-3-5-sonnet-175b5fc7de7e

📈 Résultats des évaluations :

- SeeAssign : Augmentation de la précision d’assignation des ID de 70,5 % à 93,8 %, en incorporant des sémantiques locales, évitant les confusions entre icônes.

- AITW Mobile Benchmark : Amélioration des scores de précision sur les tâches de navigation mobile de 4,7 %, surpassant des solutions comme IconNet.

- ScreenSpot Performance : Score moyen de 73,0 % sur mobile, desktop et web, contre 16,2 % pour GPT-4V seul. L’ajout de sémantiques locales améliore la correspondance des éléments d’interface.

- Polyvalence multi-modèles : Testé avec succès sur Phi-3.5-V et Llama-3.2-V, montrant une amélioration de la précision même sans informations externes comme le HTML.

🔗 Pour les développeurs et experts en vision IA : GitHub : https://github.com/microsoft/OmniParser

📄 Consultez l’article complet pour une analyse technique approfondie : https://arxiv.org/abs/2408.00203

#IA #OpenSource #VisionBasedAgent #UIParsing #Microsoft #DeepLearning #MachineLearning #InterfaceUtilisateur

🎉 Microsoft dévoile un outil révolutionnaire : convertir les captures d’écran en actions concrètes… was originally published in P2Enjoy SAS (IA & Web3) on Medium, where people are continuing the conversation by highlighting and responding to this story.