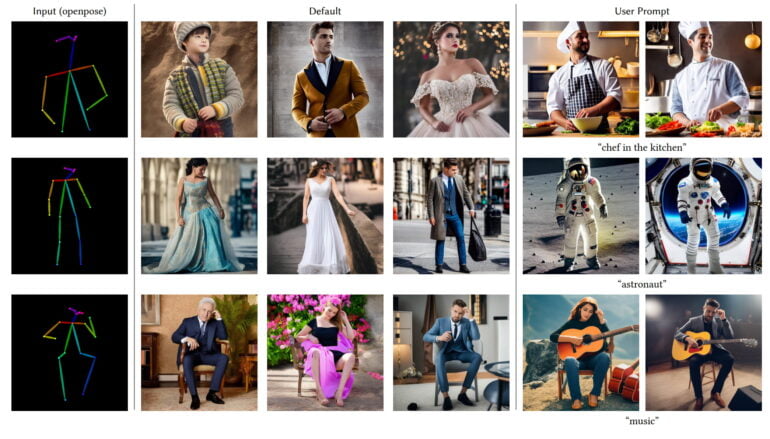

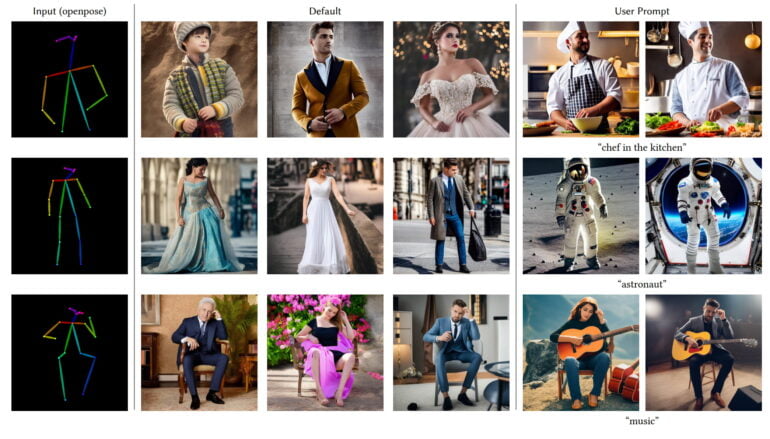

Human pose recognition enables consistent results for new character generations. | Image: Zhang, Agrawala

Imaginez pouvoir donner à une intelligence artificielle (IA) des instructions précises pour créer une image spécifique. Vous voulez une image d’un chat assis sur un canapé rouge dans un salon lumineux ? Pas de problème. C’est là que ControlNet entre en jeu.

🎨 ControlNet, l’artiste IA 🎨

Il s’agit d’une nouvelle technologie dans le monde de l’IA qui permet de « contrôler » comment une image est générée. Il s’agit d’une avancée majeure par rapport aux modèles de diffusion traditionnels, qui peuvent créer de superbes images, mais qui ont du mal à produire des détails spécifiques. Avec cette technique, vous pouvez donner à l’IA des instructions plus précises, comme des contours, des poses humaines, des cartes de profondeur, et bien plus encore. Cela rend les modèles de diffusion beaucoup plus flexibles et utiles.

🔧 Comment ça marche (en termes simples) 🔧

ControlNet fonctionne un peu comme un chef d’orchestre. Il prend un modèle de diffusion existant – qui est comme un orchestre d’IA capable de jouer une belle symphonie d’images – et lui donne des instructions plus précises sur ce qu’il doit jouer. Il fait cela en créant une « copie entraînable » du modèle de diffusion, qui peut apprendre à partir de nouvelles données et conditions.

🎉 Les avantages d’une « copie » intermediaire 🎉

L’un des grands avantages de ControlNet est qu’il peut apprendre rapidement et efficacement, même avec de petits ensembles de données. Cela signifie qu’il peut être formé sur des appareils personnels, ce qui le rend accessible à un plus grand nombre de personnes. De plus, en ajoutant ControlNet à un modèle de diffusion, vous pouvez donner à l’IA des instructions plus précises, ce qui ouvre de nouvelles possibilités pour la création d’images.

🔬 ATTENTION AUX YEUX, CA VA PARLER TECHNIQUE 😅

ControlNet utilise une technique appelée « couche de convolution zéro » pour apprendre de nouvelles conditions. Cette couche est simplement une couche de convolution avec des poids et des biais introduits à zéro. Au fur et à mesure de l’apprentissage, ces poids et biais sont ajustés pour optimiser la performance du modèle.

ControlNet fonctionne en tandem avec un autre modèle appelé « Stable Diffusion », qui opère dans ce qu’on appelle « l’espace latent » (on y retournera dans une autre publication 😎 ).

En savoir plus :

– https://huggingface.co/

– https://stable-diffusion-art.com/controlnet/